로 표현할 수 있다. 이를 이용해서 일정한 순서로 샘플링된 평면상의

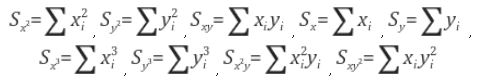

여기서

행렬을 이용해서 식을 좀 더 간결하게 표현할 수 있다.

로 쓸 수 있으므로,

위 식의 값을 최소로 하는 최소자승해는

open b-spline(cubic)

std::vector<CfPt> BSplineFit_LS(const std::vector<CfPt>& data,

const int degree, // cubic(3);

const int nc) // num of control points;

{

// open b-spline;

std::vector<double> knot((nc - 1) + degree + 2);

for (int i = 0; i <= nc + degree; i++) knot[i] = i;

std::vector<double> t(data.size()); // parameter;

double scale = (knot[nc] - knot[degree]) / (data.size()-1);

for (int i = data.size(); i-->0;)

t[i] = knot[degree] + scale * i;

// design matrix;

std::vector<double> A(ndata * nc);

for (int i = data.size(); i-->0;)

for (int j = 0; j < nc; j++)

A[i*nc + j] = Basis(j, degree, &knot[0], t[i]); //A(i,j)=N_j(t_i)

// scattering matrix: S = A^t * A; real-symmetric matrix;

std::vector<double> S(nc * nc);

for (int i = 0; i < nc; ++i)

for (int j = i; j < nc; ++j) {

double s = 0;

for (int k = data.size(); k-->0;)

s += A[k*nc + i] * A[k*nc + j];

S[i*nc + j] = s;

}

// fill lower triangle;

for (int i = 0; i < nc; ++i)

for (int j = 0; j < i; j++)

S[i*nc + j] = S[j*nc + i];

std::vector<CfPt> X(nc);

// X = A^t * P;

for (int i = 0; i < nc; i++) {

double sx = 0, sy = 0;

for (int k = data.size(); k-->0;) {

sx += A[k*nc + i] * data[k].x;

sy += A[k*nc + i] * data[k].y;

};

X[i] =CfPt(sx, sy);

};

// psinv(A, n) = inverse of real symmetric matrix A;

// ccmath-2.2.1 version;

if (0 == psinv(&S[0], nc)) {

std::vector<CfPt> Q(nc);

for (int i = 0; i < nc; ++i) {

souble sx = 0, sy = 0;

for (int k = 0; k < nc; ++k) {

sx += S[i*nc + k] * X[k].x;

sy += S[i*nc + k] * X[k].y;

}

Q[i] = CfPt(sx, sy);

}

return Q; // estimated control points;

}

return std::vector<CfPt> ();

};**네이버 블로그 이전;

'Computational Geometry' 카테고리의 다른 글

| Approximate Distance Between Ellipse and Point (0) | 2024.03.08 |

|---|---|

| Distance from a Point to an Ellipse (0) | 2024.03.06 |

| Closest Pair of Points (0) | 2021.04.27 |

| DDA Algorithm (0) | 2021.04.25 |

| B-Spline (1) | 2021.04.25 |